Le futur et l’IA : qu’est-ce qui nous attend vraiment au bout du chemin ?

Comment l’intelligence artificielle va-t-elle évoluer au cours des prochaines années ? Après ChatGPT, qu’est-ce qui nous attend ?

Rencontre du CERA du 06 février 2024

Pierre COLLET prend la parole :

Merci, merci, bien sûr, à toute l'équipe du CERA de m'avoir invité, c'est un grand plaisir d'être avec vous ce soir.

Alors, je crois que toutes mes conférences sont différentes, dans le sens où je les refais à chaque fois, parce qu'en fait le domaine change à chaque fois, donc là j'ai refait celle-là dans le train, on va voir comment elle va se passer, c'est bien, ça va être une surprise pour moi aussi. Alors, je vais essayer de tenir dans une heure et demie, parce qu'on a pas mal de choses à voir ensemble, explorer pas mal de domaines pour remettre tout ça ensemble, c'est quand même un gros sujet. Alors, avant tout et avant la conclusion de cette conférence, il faut que vous sachiez que je suis par nature un grand optimiste, et j'espère, je compte sur le débat qui aura lieu sur les questions-réponses après la conférence pour essayer d'égayer un peu la soirée.

Bon, qu'est-ce que je veux dire ? Je suis désolé, ces transparences sont en anglais, mais je vais parler en français dessus, donc s'il y a des points qui ne vont pas, ça sera quand même compréhensible. Donc on va avoir un certain nombre de points, là vous voyez 4 points, j'espère rentrer suffisamment dans ces points de manière qu'on puisse aller cheminer ensemble vers la fin. Alors, je vais commencer un peu par la fin, justement, avec cette petite citation de T.S. Eliot, ce qu'on appelle le début est souvent la fin, et terminer c'est en fait savoir commencer, et la fin c'est l'endroit d'où on part. Alors, je ne sais pas si vous connaissez cette personne-là.

Voilà, donc elle s'appelle Lil Miquela, et gardez-la en tête, on va reparler à la fin, c'est pour ça que je commence par la fin. Mais avant de parler de Lil Miquela, petite incise, qui est-elle ? Elle est née en 2016, ça ne lui fait pas beaucoup d'années. Elle a plus de 2,8 millions de followers sur Instagram en 2023, mais on est déjà en 2024. Ses meilleurs clips sur YouTube font entre 7 millions et 4 millions de vues. Elle a des contrats avec Prada, Calvin Klein, etc. Et il se trouve que cette personne n'existe pas, elle est complètement virtuelle, c'est un avatar, et on va voir l'implication que tout ça a à la fin de cette présentation. Bon, donc, parler de l'intelligence artificielle et d'éthique, remettre un peu tout ça dans le même sac, pour ça il faut arriver à peut-être définir un peu ce que c'est que l'intelligence, avant de parler de ce que c'est que l'intelligence artificielle. On va faire un peu de science quand même, ce soir, je n’espère pas trop, pour pas vous ennuyer de trop, mais c'est important. Et donc on va commencer avec la notion d'ontologie, qui est essentielle pour comprendre tout ce qui s'est passé dans l'Occident sur le développement des sciences, et bien sûr après de la notion d'intelligence.

Alors on va faire beaucoup d'étymologie ce soir, c'est très important, parce que la signification des mots, l'étymologie des mots, je ne sais pas qui c'est qui a fabriqué les mots, mais les mots ont toujours une signification profonde, merveilleuse, et vous allez voir qu'à chaque fois qu'on prend un mot, qu'on comprend ce qu'il veut dire, d'où il vient, c'est toujours éclairant. Alors, bon, philosophie, c'est le fait d'aimer la connaissance, la poursuite de la sagesse, on va faire un peu d'épistémologie, on va regarder ce qu'il y a un peu au-dessus de tout ça, pour essayer de faire un peu de théorie, voir le divin, c'est ça l'étymologie du mot. Donc, l'objet de la philosophie c'est effectivement la quête de la connaissance, pour comprendre la nature fondamentale de tout ce qui est la connaissance, réalité, existence, tout le monde qui est autour de nous, et actuellement on a vraiment ce défaut de penser que la philosophie c'est du côté de la littérature, et en fait pas du tout, c'est la science, c'est la compréhension du monde qui est autour de nous. Donc c'est absolument fondamental, et d'autant plus que maintenant, avec l'IA, vous allez voir que ça va nous interroger très sérieusement. Alors, intelligence, étymologie et signification, donc un inter léger, relier les choses et trouver les mots pour arriver à rassembler un certain nombre de concepts ensemble, donc là j'ai pris des références tout bêtement sur Wikipédia. En anglais, ça a aussi cette connotation un peu militaire, il y a la CIA, Signed Front Intelligence Agency, intelligence en anglais, ce sont aussi les informations en temps de guerre pour savoir de quoi est fait l'ennemi, etc.

Donc il y a aussi cette petite connotation qui n'existe pas en français. Bon, alors, regardons un peu comment tout ça a commencé, et ça a commencé il y a très longtemps avec Parménide, en Occident. Parménide c'est un philosophe grec, il y a 2500 ans maintenant, et en fait c'est lui qui a attiré l'attention et qui a permis à toute la science occidentale de se développer, parce qu'en fait il a attiré l'attention des philosophes de l'époque, donc les scientifiques de l'époque, qui s'appelaient des philosophes, sur le fait de dire que le monde est composé d'objets, d'entités, et qu'il ne s'agit pas de construire sur des fondations qui sont en sable.

Donc avant d'élaborer des concepts, il faut s'assurer que le concept précédent qui est dessous, il est solide, il a été vérifié, et que ce n'est pas quelque chose de flou, sur lequel on n'est pas sûr. Parce que si vous construisez une maison sur un tas de sable, forcément, si les fondations ne sont pas bonnes, la construction risque de ne pas être très solide. Ensuite, il a dit que ce qui est, et ce qui n'est pas, ne peut pas être. Donc c'est très important de bien comprendre la détermination des choses, où les choses commencent, où les choses terminent, pour s'assurer de quoi il s'agit avant de pouvoir continuer. Maintenant qu'on a défini la notion d'objet, il faut comprendre comment les objets interagissent entre eux. Cette notion d'interaction entre eux, on va le voir, c'est ce qui consiste les ontologies. En fait, ça se fait via des lois. Il faut reprendre les définitions des mots, etc. Comment est-ce qu'on va relier les objets ensemble ?

En fait, ça va se faire par un graphe. Pour les gens qui font de l'informatique, c'est un graphe qui ressemble à ce qu'on appelle un arbre en informatique. En informatique, les arbres sont un peu bizarres. La racine de l'arbre est en haut, les feuilles sont en bas. Généralement, à partir de la racine qui est en haut, on descend, mais les flèches vont de haut en bas. Alors que dans une ontologie... Alors là, j'ai tapé le mot ontologie sur internet, j'ai essayé de trouver un truc. C'est la première ontologie qui est arrivée. Je l'ai trouvé très bien. Vous voyez qu'ici, c'est une espèce d'arbre, mais avec les flèches qui vont du bas vers le haut.

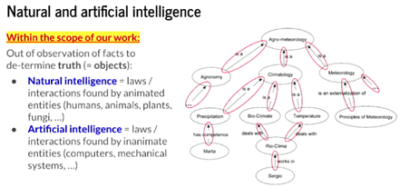

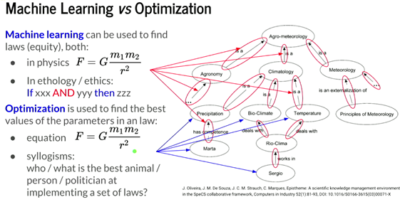

Maintenant, quand on regarde un peu de quoi il s'agit, c'est une ontologie sur l'agrométéorologie. J'ai un pointeur un peu magique ici. Je ne sais pas comment ça va passer dans la vidéo. C'est l'agrométéorologie ici. On se rend compte qu'il y a Sergio qui est là, peut-être. Sergio qui travaille dans le rio climat, qui lui-même travaille sur la notion de bioclimat, qui fait partie de la climatologie, qui est une agrométéorologie. Martha a des compétences en précipitation, qui fait partie de la climatologie, etc. C'est comme ça qu'on arrive à définir un domaine à partir d'un certain nombre d'entités. Comment est-ce que ces entités sont reliées ensemble ? C'est ce qu'on appelle une ontologie, c'est le graphe des connaissances et comment les connaissances sont reliées entre elles. D'un point de vue informatique, parce que l'IA est reliée très fortement à l'informatique, c'est la science des données, etc. Il faut comprendre que pour nous, tous les objets qui se trouvent là, les entités, c'est ce qu'on appelle les données, la science des données, etc. Finalement, c'est ça qui définit en philosophie ce qu'on appelle la vérité.

La vérité, il faut savoir qu'en dehors des mathématiques, elle n'existe pas. C'est quoi la vérité de cette télécommande ? Quelle masse fait-elle exactement au sens mathématique du terme ? Il faut que je connaisse tous les atomes qui la composent. C'est quoi sa couleur exacte ? On se rend compte qu'à la fin, quand on descend au niveau atomique, en plus tout est flou, on descend dans la physique quantique, il n'y a plus rien de déterminé. Les objets, on ne sait pas où ils sont, on ne peut pas déterminer leur vitesse et leur position à la fois. Donc à la fin, il n'y a plus rien. Voilà, super, parfait. Finalement, c'est quoi l'objet de la science ? D'où vient le mot science ? L'objet de la science, ça vient de syndérer, c'est scinder. Et l'objet de la science, c'est de faire la part entre le vrai et le faux. Entre séparer le bon grain de l'ivraie, qu'est-ce qui est déterminé, qu'est-ce qui n'est pas déterminé. C'est ça l'objet de la science, trouver ce qui est vrai, trouver ce qui est faux. C'est ça l'idée de ces objets, comprendre ce qu'ils sont. Et ensuite, la deuxième partie, c'est avec les lois. Ça consiste à trouver comment les objets sont reliés entre eux et quelle est leur interaction. Et en science, on fait ça avec des équations. Les équations définissent ce qu'on appelle des lois. En latin, la loi provient de ius, qui a un rapport avec la justice.

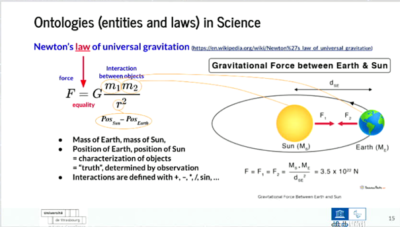

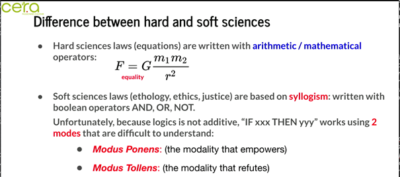

La justice, la loi, ce sont des mots qu'on utilise assez souvent ensemble. Quel est l'objet de la justice ? C'est de trouver l'égalité. C'est pour ça qu'on a la balance qui se trouve ici. La balance de la justice, c'est celle qui doit déterminer ce qui est égal. Si vous voulez une pomme, la pénalité ne sera pas la même que si vous voulez un œuf ou un bœuf. C'est ça l'idée, c'est d'arriver à trouver le bon équilibre des choses. C'est ça l'égalité, la justice, la loi. C'est mettre les choses en rapport. Maintenant, quand on ramène ça sur la notion de science, il y a une loi qui est très connue en science, une des premières qui a démarré la révolution scientifique du XVIIe siècle. C'est la loi universelle de la gravitation de Newton. Cette loi dit quoi ? La loi veut dire qu'il y a une égalité ici, si j'arrive à contrôler mon truc, il y a une égalité, c'est ça la notion de loi, entre la force d'attraction entre deux corps et une équation qui détermine cette force. Cette force est déterminée à partir de quoi ? C'est la masse d'une entité, un objet ici, fois la masse du deuxième, divisé par la distance au carré entre les deux. La distance entrée au carré entre les deux, c'est la position de l'un moins la position de l'autre, et tout au carré. C'est ce qu'on appelle une loi en science, c'est la loi universelle de la gravitation. Il n'y a pas qu'en science qu'on fait des lois, j’ai discuté avec un avocat aujourd'hui, il y a aussi les interactions humaines. Ce ne sont pas des cailloux qui interagissent entre eux, des fois on appelle ça les sciences dures, c'est la science des cailloux, les planètes, la Terre, quand on recevait un caillou dans la figure, et puis après il y a les sciences humaines, et en sciences humaines on a aussi des lois. Elles sont définies comment ?

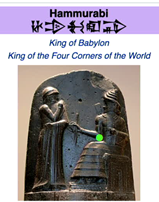

Je vous présente Hammourabi, qui est debout, qui a les mains en signe de prière, devant le dieu Shamash, ou peut-être Marduk, qui lui donne une liste de lois, parce qu'à l'époque, il y a 3700 ans, et depuis le début de l'humanité, on vivait dans une époque où les lois provenaient des dieux, c'est ce qu'on appelle un système hétéronome, Nomos en grec ça veut dire loi, hétéro ça veut dire que les lois venaient d'ailleurs, donc actuellement nous sommes en France dans un gouvernement autonome, dans le sens où les lois sont faites par le parlement, les députés, les sénateurs, etc.

Donc ce sont des humains qui font les lois pour d'autres humains, mais à cette époque-là, les lois étaient des lois divines, et donc c'est pour ça que c'est un système hétéronome. Alors c'est très intéressant parce qu'on a retrouvé cette stèle, et dans cette stèle qui est faite en basalte, écrite en cunéiforme verticalement, maintenant qu'on a réussi à comprendre le cunéiforme, on a réussi à comprendre ce qu'étaient ces lois, et de quoi elles étaient faites. Alors je vous en ai pris une, il y en a environ 125, 150, qui sont toutes écrites comme ça, et qui décrivaient la manière dont les humains devaient interagir. Dans ces cas-là, les entités, ce sont les humains.

Les interactions, ce ne sont pas des équations. Ah, finalement, ce ne sont pas des équations. Alors ça dit quoi ? Une des lois dit, si un humain, à l'époque c’étaient des hommes, il y a toute une hiérarchie, on y reviendra après. Si un homme a une dette contre lui, qu'il a empruntée, et que le dieu des tempêtes, Hadad, dévaste son champ, ou alors s'il y a une inondation qui a emmené toutes ces céréales, ou s'il n'y a pas de grain qui a poussé dans son champ à cause du fait qu'il n'y a pas assez d'eau, là ça gère trop d'eau, là ça ne gère pas assez d'eau, là ça gère le vent, ça essaie de tout gérer. Alors, dans cette année, dans l'année où ces catastrophes se sont produites à cause du dieu Hadad, il n'aura pas à redonner du grain à son créditeur, le contrat sera interrompu pendant toute cette année, et il n'aura pas besoin de payer d'intérêts pendant toute cette année.

Il y avait déjà la notion d'intérêt, c'est sympa, ce n'est pas sa faute, donc pas d'intérêt sur le fait qu'il doit de l'argent, qu'il n'a pas pu rembourser. Outre la loi qui est elle-même intéressante, ce qui est intéressant c'est de regarder quand c'est une loi scientifique, ça a été fait avec des plus, des moins, des multipliés, des divisés, ce genre de choses, c'est ça les opérateurs. Et là, c'est quoi les opérateurs ? Il y a un if-then, c'est si on se retrouve en informatique, tiens, if-then-else, donc si une condition, mais cette condition, vous voyez qu'elle contient des ou, et puis il y a des non.

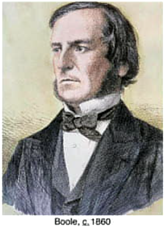

Tiens, et ou non, c'est ce qu'on appelle les opérateurs logiques. Les opérateurs logiques, on se retrouve dans le monde de l'information, dans le monde des ordinateurs à cette époque-là. Et donc, qu'est-ce qu'on a ? En fait, si une condition, alors une autre condition, c'est ce qui définit l'égalité, c'est ce qui définit ce qui est juste. Donc en fait, le if-then, c'est l'équivalent du signe égal. D'accord ? Si ceci se produit, alors il est égal, il est juste que cette pénalité soit appliquée. Alors, maintenant, ça nous amène vers quoi ? Ça nous amène vers le fait que lorsque les lois sont des lois humaines, des lois qui déterminent le comportement des entités animées les unes entre les autres, donc quand c'est des animées non humaines, on appelle ça l'éthologie, la science du comportement, lorsque ce sont des animées humaines, la manière dont on doit interagir entre nous, ça s'appelle l'éthique. Le comportement entre les humains. Donc on se rend compte que finalement, il est fait avec de la logique. Alors, c'est qui la logique ? En fait, la personne qui a bien compris tout ça, c'est Georges Boole, c'est pour ça qu'on a des boulins. Les boulins, c'est comment est-ce qu'on détermine des informations qui sont vraies, fausses, et comment est-ce que le vrai et le faux se combinent ensemble. Alors, quelle est l'étymologie de logique ?

Eh bien, on va revenir dessus à la fin de cette présentation. C'est la notion de logos, raison, idée, etc. Mais ce sont aussi les premières phrases du prologue de Saint-Jean, de l'évangile selon Saint-Jean. On va voir l'importance que ça a tout à l'heure. Alors maintenant, ça nous amène on sait à peu près ce que c'est plus ou moins multiplié mais les gens savent beaucoup moins ce que c'est que la logique et comment fonctionnent les logiques et les opérateurs logiques. Alors, la logique, c'est l'étude du raisonnement. C'est important, bien sûr, en intelligence artificielle parce que ça a tout mélangé, l'intelligence artificielle.

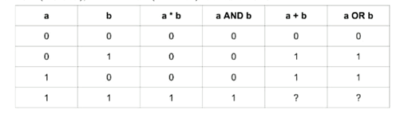

Et donc, on va regarder un peu ce que c'est que l'algèbre booléenne. Et en fait, l'algèbre booléenne, ça ne fonctionne pas comme une algèbre arithmétique, plus et moins. Donc, il se trouve qu'on a aussi des opérateurs. Alors, on a un opérateur dont on a déjà parlé un petit peu avant, et on a un opérateur et finalement, c'est très très similaire à l'arithmétique générale qui a deux lois. Alors, c'est quoi les lois ? Eh bien, voilà, si j'ai A qui vaut 0 ou B qui vaut ces valeurs-là ici. Donc là, la première ligne, ça va être quand A et B valent 0 et 0. A fois B, 0 fois 0, ça fait 0. A et B, tiens, donc faux et faux, ça fait faux. C'est 0 aussi. Et si j'ai A plus B, donc l'opérateur arithmétique, 0 plus 0, ça fait 0. Et A ou B, tiens, ça fait 0 aussi. Et on se rend compte qu'il y a une similarité très proche entre la notion de et la notion de multiplier. Vous voyez que 0 fois 1, ça fait 0. Eh bien, 0 faux et vrai, ça fait faux.

Vrai et faux, ça fait 0, etc. Vous voyez que c'est exactement la même chose. Et là, quand j'ai 1 fois 1, ça fait 1. Eh bien, vrai et vrai, ça fait vrai. Donc de ce côté-là, il n'y a pas de problème. Maintenant, quand je regarde du côté de l'addition, eh bien, 0 plus 0, ça fait la tête à totaux. 0 plus 1, ça fait 1. 0 ou 1, ça fait 1. Faux ou vrai, ça fait 1. Vrai ou faux, 1 plus 0, ça fait 1. Vrai ou faux, ça fait 1. Maintenant, je vais vous poser des questions. D'après vous, ça fait quoi ? 1 plus 1 ? Est-ce que vous savez ce que ça fait, 1 plus 1 ?

Souvent, ça fait 2. D'accord. Et d'après vous, ça fait quoi vrai plus vrai ? En fait, c'est ça le gros problème. C'est que vrai plus vrai, ça fait vrai. Et ça ne fait pas 2 fois vrai. Et donc, ce qu'on comprend ici, c'est que l'addition, l'arithmétique, elle est ce qu'on appelle additive. 1 plus 1, ça fait 2. Alors que la logique n'est pas additive. Quelque chose qui est 10 000 fois vrai, c'est quelque chose qui est vrai. D'accord. Et le problème, l'énorme problème qu'ont les ordinateurs, c'est que les ordinateurs, ils travaillent avec vrai et faux. C'est des opérateurs booléens. Donc ce que vous avez, les ordinateurs ne savent pas compter, il ne faut pas le dire.

Si vous demandez à l'ordinateur combien ça fait 1 plus 1, l'ordinateur va lui dire que ça fait 1. Pourquoi ? Parce que l'ordinateur, il fonctionne avec du vrai. Et pour un ordinateur, vrai ou vrai, c'est-à-dire vrai plus vrai, ça fait vrai. Ça ne fait pas 2 fois vrai. Alors c'est très intéressant parce que, en informatique, la manière dont on implémente le vrai et le faux, le vrai c'est 5V, il y a un courant dans un fil, le courant c'est plus 5V, le faux c'est 0V. Donc heureusement que ce n'est pas additif parce que si je cherche à 5V plus 5V, si c'était additif, ça devrait faire 10V.

Et puis si je cherche à afficher ce qu'il y a sur mon compte en banque, si j'ai 2000€ sur mon compte en banque, tout d'un coup l'ordinateur devrait afficher 10000V, alors il faut que je m'en arrête. Forcément, parce que si j'additionne les volts... Vous voyez bien que c'est un gros problème. Heureusement, quand j'affiche 1 million, je n'ai pas 5 millions de volts qui sortent de mon ordinateur. Et j'en suis très heureux. Mais ça veut dire qu'on a un très gros problème, c'est qu'on ne sait pas faire calculer les ordinateurs. Il faut faire des circuits logiques pour faire des additions, pour faire des soustractions, des divisions, des multiplications.

C'est tout un binz parce qu'on essaye de faire du calcul avec des machins qui ne savent pas calculer. Parce qu'ils sont basés sur la logique. Alors maintenant, qu'est-ce que c'est qu'être basé sur la logique ? On va voir que ça a d'autres influences. C'est que si avec les sciences dures, la science des cailloux, les lois c'est des égalités, nous, c'est quoi le mécanisme déductif de logique qui permet de fabriquer ? C'est quoi l'égalité dans la notion de logique ? L'égalité dans la notion de logique, c'est ce qu'on appelle le syllogisme.

Je ne sais pas s'il y en a qui ont fait un peu de loi, un peu de juridique. Le syllogisme, c'est le syllogisme que doit être basé toute la législation, toutes les lois. Et si un jour vous allez au tribunal, les avocats, le procureur, les juges, etc., doivent baser leur raisonnement sur le syllogisme. Et malheureusement, vous allez voir que le syllogisme, ce n'est pas un truc qui est facile à comprendre et du coup, ce n'est pas un truc qui est très compris, y compris des spécialistes du domaine. Alors, ça fonctionne en utilisant deux modes.

Le premier mode, c'est le modus ponens. C'est la modalité qui donne le pouvoir, c'est ça qui donne le pouvoir à la justice de vous mettre en prison ou pas. Et il y a l'inverse du modus ponens, c'est la modalité qui réfute les choses. On va voir comment ça fonctionne. Alors, la personne qui a compris ça, tout a été inventé en Grèce il y a plus de 2000 ans, même l'IA, on va voir qu'il y a tout plein de choses. Ils avaient tout compris, les Grecs. Alors, c'est Théophraste de Lesbos et William de Rode qui ont travaillé sur le syllogisme qui veut dire inférence, conclusion.

Donc, comment ça fonctionne ? C'est l'aspect performatif de la loi. Donc, si on a A implique B qui est vrai, on a une proposition. Ensuite, si A est vrai, alors ça signifie que B est vrai. La manière dont on traduit ça habituellement en philo, c'est de dire on a une proposition qu'on fait, on va dire si tous les humains sont mortels, ça, ça va être humain implique être mortel.

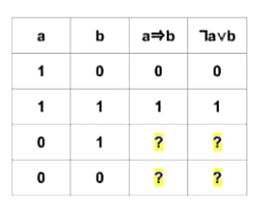

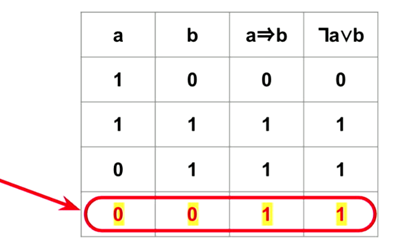

Alors, si Socrate est humain, et voilà, si A est vrai, ça implique que Socrate est mortel. Alors, d'un point de vue table de vérité, c'est comme ça qu'on fait en informatique. Je reprends mes A, B, 0, 1, etc. Alors, ça, on arrive à comprendre à peu près, et c'est très important c'est la vie de tous les jours, c'est comment est-ce qu'on interagit avec les gens, c'est basé sur la logique, c'est basé sur cette déduction. Donc, la déduction, c'est que si je pars d'un truc vrai, vrai implique faux, bah non, ce n’est pas vrai, donc là, l'implication elle est fausse. Maintenant, vrai implique vrai, ah bah oui, bien sûr, c'est vrai, c'est-à-dire que, là, dans ces cas-là, tout se passe bien, il n'y a pas de problème. Et alors là, ce que les gens ont du mal à comprendre, et malheureusement, les professionnels aussi de la justice ont du mal à comprendre ça, c'est que, d'après vous, qu'est-ce qui se passe si je commence avec une prémisse fausse ? C'est-à-dire que, si Socrate n'est pas un humain.

Et est-ce que le fait que Socrate ne soit pas un humain, soit que je suis capable de déduire que Socrate est immortel ? Ou est-ce que le fait que Socrate ne soit pas un humain me permet de décrire que Socrate est mortel ? D'après vous, c'est quoi l'implication ? En fait, c'est la même chose à gauche et à droite, pour vous montrer que l'implic, qui est ici le syllogisme, il a une transcription en logique, c'est non A ou B. C'est comme ça qu'on décrit ça en matière logique. D'après vous, si les prémisses sont fausses, qu'est-ce qu'est la conclusion ? Là, j'ai quelqu'un qui dit 1, j'ai quelqu'un qui dit faux.

Alors, faux, est-ce qu'on va faire un truc à main levée ? Généralement, malheureusement, les gens pensent que si la prémisse est fausse, et bien forcément, la déduction et le reste est complètement faux. Et là, je vais peut-être vous surprendre un peu, c'est qu'en fait, c'est toujours vrai. Alors, l'idée profonde et importante à comprendre qui est derrière ça, c'est que si je commence d'une idée fausse, de quelque chose qui est faux, je peux tout déduire d'un truc qui au départ était faux. Vu qu'au départ, c'était faux. Par exemple, voilà, j'ai 10 milliards d'euros, donc je vais voir Beneteau et je vais dire, je veux acheter ce bateau qui coûte 5 millions d'euros, j'ai 10 milliards, donc donnez-le moi. Ben, en fait, possiblement, si je les ai, on peut me le donner le bateau, mais en fait, je ne les ai pas.

D'accord ? Donc en fait, ce qu'il faut comprendre, c'est qu'à partir d'une prémisse fausse, si je dis j'ai 10 milliards d'euros, je peux tout acheter. Donc là, de ce côté-là, ça, ça valide le truc, mais malheureusement, dans la réalité, ce n’est pas vrai. Donc là, il y a une grosse différence à faire entre le concept qui est, quand je pars d'une chose fausse, tout devient possible, parce que de toute façon, au départ, c'était faux. Mais alors après, dans la réalité, ce n’est pas la même chose. Donc on va voir un peu l'implication de ce truc-là.

Donc c'est ça qu'il faut comprendre, il faut se souvenir de ça, c'est qu'en logique, faux implique vrai, c'est vrai, et faux implique faux, c'est vrai aussi. En partant d'un truc faux, je peux tout déduire, ce que je veux. C'est très important à comprendre ça. Alors maintenant, pourquoi c'est important ?

J'ai tapé ici, hier, le syllogisme juridique, définition exemple, j'ai pris ça sur le web, par Maxime Bizeau. Donc si vous êtes étudiant en droit, vous devez impérativement comprendre et maîtriser le syllogisme, d'abord parce que le syllogisme est le raisonnement par action du juriste. Un juriste n'est pas quelqu'un qui apprend par cœur son code civil, mais quelqu'un qui raisonne à l'aide du syllogisme juridique que personne ne comprend.

Voilà.

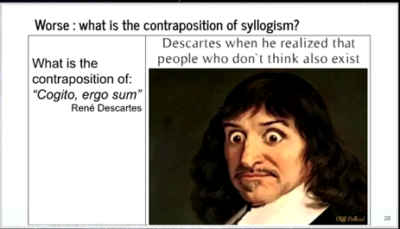

Parce que là, pour l'instant, ça va, parce qu'on le fait dans le bon sens, mais ça titille les gens, que faux implique vrai, ça soit vrai. Que faux implique quelque chose, ça soit vrai. Bon, alors après, il y a le pire, qu'est-ce que c'est que la contraposée du syllogisme ? La contraposée du syllogisme, c'est quand j'ai l'implication, dont je pense qu'il est vrai, comment est-ce que j'inverse ça ? C'est le fameux Moses-Tolens, c'est le fait de réfuter les choses.

Eh bien, la plupart du temps, donc je vais dire, voilà, si A implique B est vrai, alors comment est-ce que je remets l'inverse ? Les gens disent, voilà, si A implique B est vrai, mon truc ne marche plus, il est là, eh bien la réfutation de ce truc-là, ça doit être de dire, si A est faux, alors B est faux. Mais en fait, c'est pas ça, parce que vous voyez bien que si A est faux, alors tout le reste est vrai. Donc la manière dont ce truc-là s'inverse, ça s'inverse en renversant les deux propositions. C'est-à-dire que, alors on va le faire ensemble, si tous les humains sont mortels et vrais, si Zeus n'est pas mortel, donc si B est faux, alors ça veut dire que Zeus n'est pas humain.

Et ça, ça fonctionne bien, ça s'inverse bien, ce syllogisme s'inverse bien si on part de B, donc ça veut dire que lorsque B est faux, A sera faux. Mais ça ne veut pas dire que lorsque A est faux, B est faux. Parce qu'encore une fois, lorsque A est faux, quand on démarre d'un truc faux, tout le reste devient vrai. Donc ça s'inverse, et ça, ça fait des nœuds dans les neurones de tout le monde. Alors, la preuve, c'est que j'ai vu il y a trois semaines, il y a un mème qui est arrivé sur Internet, et vous allez voir que c'est assez amusant, il y a quelqu'un qui a fait justement une proposition comme ça, qui s'appelle René Descartes, cogito ergo sum, je pense, donc je suis, et donc est apparu, il y a quelque chose comme deux, trois mois, cette image-là sur Internet.

Et donc ça, c'est la tête de Descartes quand il a pris conscience que les personnes qui n'existent pas, que les personnes qui ne pensent pas existent aussi. Donc je pense, donc je suis, donc pour les personnes, si je ne pense pas, donc je n'existe pas. Et c'est quand il a rendu compte que, bah non, il y a un mec qui ne pense pas, il existe. Donc vous voyez la tête qu'il fait.

Mais est-ce que vous voyez le gros problème qu'il y a derrière ? C'est qu'en fait l'inversion du syllogisme je pense, donc je suis, elle a mal été faite. C'est-à-dire que je pense, donc je suis, ça a été inversé en disant je ne pense pas, donc je ne suis pas. Mais ce n'est pas comme ça que ça s'inverse. Je vous ai dit que ça s'inversait, la bonne manière d'inverser ça, c'est d'inverser les deux. Et si j'inverse, si je dis si B est faux, ça implique que A est faux, alors là ce que dit Descartes, ça prend tout son sens, ça dit je pense donc je suis, donc si je ne suis pas, si je n'existe pas, alors je ne pense pas. Et là c'est nickel. Et donc là ça s'inverse correctement.

Mais pour vous montrer à quel point les gens ne le comprennent pas, dans Stake Exchange, un endroit où les gens se posent des questions sur la philosophie, donc Stake Exchange, philosophie, question qui est posée, il y a 7 ans, est-ce que nous n'existons pas lorsque nous ne pensons pas, comme l'a dit Descartes ? Ou est-ce que nous pensons continuellement, et démarre une discussion complètement oiseuse là-dessus ? Donc avec le prémice de cette discussion sur la philosophie, est-ce que nous n'existons pas quand on ne pense pas ?

Mais ce n'est pas du tout ce qu'il a dit Descartes. Ça ne s'inverse pas comme ça. Ça s'inverse en disant, est-ce que si nous n'existons pas, nous ne pensons pas ? Bah oui, si on n'existe pas, on ne pense pas. Là, de ce côté-là, il n'y a pas de problème. Vous voyez que tout le démarrage de la discussion a été fait sur une inversion incorrecte du syllogisme, le modus tollens a été mal fait. Et donc, du coup, je suis content, j'ai trouvé, vous avez vu que je mets des petites photos des philosophes, des trucs comme ça, j'ai trouvé la photo de Théophraste lorsqu'il a lu ça en 2016, ça c'est la photo de Théophraste quand il s'est rendu compte qu'en 2016, les philosophes ne comprennent toujours pas le modus tollens, c'est la manière dont on inverse correctement les syllogismes. Voilà, ça c'est un énorme problème comme vous pouvez l'imaginer, surtout quand...

Alors, donc maintenant, revenons sur, bon, il y a des différences entre l'arithmétique et la logique, il y en a un qui est distributif par rapport à l'autre, la multiplication est distributive par rapport à l'addition, mais l'addition n'est pas distributive par rapport à l'explication, et c'est le cas en logique, il y a plein de différences comme ça qui font qu'on n'est pas dans les mêmes mondes, c'est pas la même chose, la science est la science humaine, l'arithmétique plus ou moins multipliée, divisée, ça ne fonctionne pas pareil que et où et non.

Alors maintenant, la différence entre l'intelligence artificielle et naturelle, moi ce que je propose dans mes travaux, et c'est comme ça que je fais ça, je propose de définir l'intelligence de manière extrêmement simple, je dis que l'intelligence c'est le fait d'être capable de trouver, de comprendre la relation qu'il y a entre des objets, vous avez la terre, vous avez le soleil, et ben Newton, il a trouvé la relation qu'il y avait entre les deux, c'était qu'en fait il y en a un qui attirait l'autre, suivant la force de la loi universelle de gravitation, et comme c'est son cerveau humain qui a réussi à partir des trajectoires de Tycho Brahe, de la seconde loi de Kepler, etc, il a réussi à mettre tout ensemble, et à trouver la relation qu'il y avait entre le soleil et la terre, entre le soleil et la lune, entre le machin, etc, et ben il a utilisé l'intelligence naturelle.

Et donc moi ce que j'ai fait faire l'année dernière à mes étudiants d'intelligence artificielle, c'est que j'aurais donné la trajectoire de la lune autour de la terre, et voilà, vous êtes Newton, pouvez-vous faire un programme d'intelligence artificielle qui serait capable de retrouver une loi de corrélation, d'interaction entre la terre ? Et ben ils ont trouvé, et donc leur ordinateur, ce n'est pas eux qui l'ont fait, ils ont lancé un programme d'apprentissage automatique, et bien l'ordinateur a retrouvé la loi universelle de la gravitation, de Newton.

Et ben là, dans ces cas-là pour moi, c'est de l'intelligence artificielle, parce que ce n'est pas un humain qui a trouvé la F égale G fois m1 fois m2 sur la distance au carré, c'est un ordinateur qui a trouvé ça à partir des données, à partir des mêmes données que celles qu'avait Newton. Donc voilà, ça définit relativement simplement la notion d'intelligence artificielle. Donc les objets, c'est encore une fois ce qui est là. L'intelligence, c'est la relation, c'est comment l'intelligence est gérée, la manière dont les choses sont interreliées. Quand la formulation de ce truc-là sous la forme d'une loi est faite par un humain ou un chien ou n'importe quoi, on appelle ça de l'intelligence, et quand c'est fait par une machine, on appelle ça de l'intelligence artificielle. Donc ça c'est ma définition propre, mais vous avez le droit de la reprendre si elle vous intéresse bien sûr.

Donc, machine learning, c'est ça, c'est le fait de trouver les lois. Et alors maintenant, c'est intéressant, ça permet de faire la distinction avec la notion d'optimisation. Et l'optimisation, c'est lorsqu'on a déjà la loi, on connaît cette loi qui existe, et on voit un météore qui passe dans le ciel, on voit un astéroïde. Eh bien, en connaissant une approximation de la masse de la Terre, quand on regarde la trajectoire de la météorite, on est capable d'en déduire sa masse, sa vitesse, sa trajectoire, etc. Mais dans ces cas-là, le fait de déduire la masse à partir de la trajectoire, quand on a déjà la loi, c'est ce que j'appelle l'optimisation. L'optimisation, c'est trouver les valeurs qui permettent de déterminer les objets. Donc voilà, c'est ça la différence entre les deux. Alors maintenant, regardons la notion d'intelligence. Est-ce qu'il n'y a qu'un seul type d'intelligence dans le monde ?

Eh bien, regardons un petit peu ça. Pendant des milliers d'années, l'homme, l'humain a essayé de voler, puis il n'a pas réussi. Puis maintenant, je pense qu'on est tous capables de dire, avec des vidéos comme ça, qu'on est capables de voler. On est capables de faire des trucs que les oiseaux n'arrivent pas à faire. On peut voler sur le dos. J'ai vu une mouette voler sur le dos. Non, les mouettes ne volent pas sur le dos, ni les pigeons. Mais pourtant, les avions font ça très bien.

Est-ce que nous avons réussi à voler comme les oiseaux ? Je vais vous montrer la dernière tentative à ma connaissance, qui est en 2006, de faire un avion qui vole comme un oiseau. Ça devrait démarrer. Là, c'est un avion qui a un moteur, bien sûr, mais le moteur n'est pas connecté à une hélice, à un jet ou à quoi que ce soit. Le moteur est juste connecté à des ailes. Le but du jeu, c'est d'arriver à regarder si on est capable de voler comme un oiseau. Mais là, il n'y a que les ailes. C'est quand même intéressant. Traverser l'Atlantique comme ça, il faut un gros sac vomitif. Il y a quand même le décollage. On réussit enfin en 2006 à voler comme un oiseau. Après, il faut contrôler le vol et se reposer correctement. On se rend compte que l'atterrissage et le contrôle du vol sont un peu difficiles. Voici le premier et dernier atterrissage connu d'un avion volant comme un oiseau. Pourtant, on vole, mais pas comme les oiseaux.

Ce qui nous a empêché de voler pendant des milliers d'années, c'est qu'on a essayé de voler en battant des ailes. Alors que si on essaie de voler sans battre des ailes, voilà ce que ça donne. Ça, c'est 1973, je crois. Il y a des gens qui font des deltaplanes comme ça. Ils font ça avec quoi ? Du bambou, parce que c'est une super résistance. De la toile et des cordes. Une fois que vous avez des morceaux de bois, de la toile et des cordes. Sincèrement, c'est la technologie Jésus-Christ. Jésus-Christ était habillé, il avait de la toile. Dès qu'il y a des habits, dès qu'on fait des vêtements, de la toile, on peut voler comme ça.

Pourquoi est-ce qu'on n'a pas volé comme ça pendant des milliers d'années ? C'est parce qu'on s'est obstiné. Il y a je ne sais pas combien de gens qui sont morts en essayant de battre des ailes en se jetant de la tour Eiffel. Vous avez toutes les vidéos qui sont comme ça. Le problème, c'est de battre des ailes. Nous, on ne sait pas faire. Mais si on accepte de ne pas battre des ailes, c'est bien. On vole très bien, mais pas comme les oiseaux. Maintenant, si je ramène ça à la notion d'intelligence, est-ce que les avions volent comme des oiseaux ?

Est-ce que les sous-marins nagent ? Est-ce que vous avez vu des sous-marins qui avancent en se tortillant ? Non, les sous-marins ne s'avancent pas en se tortillant. Et donc, pourquoi est-ce que l'IA devrait avoir une intelligence qui serait de la même nature que l'intelligence humaine ? En fait, c'est de fabriquer des contraintes qui finalement n'ont peut-être pas besoin. Encore une fois, on sait voler, mais pas comme les oiseaux. Est-ce que d'autres animaux sont intelligents ?

Là, on a un oiseau. Une tête de linotte. Les linottes, ce n'est pas très intelligent. C'est une espèce de héron. Il est à la pêche. Il a compris que les poissons aiment les morceaux de pain. Il a été faucher un petit morceau de pain. Et puis, il est à la pêche. Qu'est-ce qu'il va faire ? C'est là où on voit la notion d'intelligence. Il met son morceau de pain en attendant qu'un poisson... Pas n'importe quel poisson, parce qu'il y a des poissons qui sont super gros. Là, il est plus gros que le moineau. Forcément, il va se faire bouffer son morceau de pain. Comme c'est son morceau de pain qui est son appât, il n'a pas envie de se le faire manger par des poissons qu'il n'est pas capable d'attraper. Qu'est-ce qu'il fait ? Il attend que les gros poissons passent. Ça y est, il n'y a plus de gros poissons. Là, il l'a pris parce qu'il y a des poissons qui sont trop gros pour lui.

Donc, il attend. C'est comme la pêche, il faut attendre. Je reprends ça parce que je vais me le faire bouffer. Et ceux-là, je ne peux pas les manger. Après, ils sont partis. Non, là non plus, ça ne va pas. Il est à la pêche. Au bout d'un moment, il a trouvé son petit poisson de la bonne taille. Parce que lui, il ne mange pas de pain, il mange des poissons. Là, il y a quand même de la réflexion. Quand c'est des gros poissons, il prend son morceau de pain. Il avait déjà trouvé l'idée d'aller pêcher avec un morceau de pain. Enfin zut, c'est incroyable. Donc, si les gens disent que les animaux sont bêtes, on appelle ça des bêtes d'ailleurs, c'est pour ça que ce n'est pas intelligent. Là, le truc-là, il avait quelques neurones dans sa tête. Alors, d'après vous, les plantes, est-ce qu'elles sont intelligentes ? Est-ce qu'elles sont capables d'apprendre ? Et d'apprendre comment ?

Je vois les gens qui font des grimaces. C'est intéressant de vous parler à votre plante tous les jours. Elle vous est reconnaissante ou pas ? Alors, il y a un test d'apprentissage qui est très connu, qui s'appelle le test de Pavlov. Alors Pavlov, vous avez peut-être entendu parler de ça. C'était donc le test, c'est qu'on prend un chien, on le met dans une cage, il n'a rien à manger. Et puis, ce qu'on fait, c'est qu'on fait sonner une petite sonnette. Et puis, disons, 30 secondes ou une minute après que la sonnette sonne, on apporte de la nourriture.

Au bout de quelques fois, le chien, qui n'est pas bête non plus, il a fait la relation entre deux entités. Entre l'entité sonnette et l'entité, il y a de la bouffe qui arrive. Donc, il a fait preuve d'intelligence. Et donc, on fait sonner l'un. Et puis, au bout d'un moment, le chien, il a appris. Et quand la sonnette sonne, il se met à saliver. Il est tout content, il a mis la queue et il attend la bouffe. Donc, la question, c'est est-ce qu'on peut transposer ça aux plantes ? Eh bien, en fait, ça a été fait il y a relativement peu de temps et de façon superbe en 2016, encore une fois. Donc là, ils se sont dit, vous savez qu'il y a des tournesols. Les tournesols tournent avec le soleil. Jusqu'à maintenant, on avait une interprétation des plantes qui tournaient avec le soleil, que c'était la partie à l'ombre de la tige qui poussait plus rapidement que la partie au soleil.

Donc, si vous avez le soleil qui est face à une fleur, forcément, la partie de la tige qui est à l'ombre poussant plus vite, ça va orienter la fleur par ici. Si le soleil se déplace, qu'il va à droite, la partie à l'ombre se déplace. Et donc, finalement, on a une plante qui tourne avec le soleil. Et puis là, on explique les tournesols. Et puis, il n'y a pas de problème. Eh bien, jusqu'en 2016, les gens se sont dit, voyons voir, essayons de refaire l'expérience de Pavlov.

Et puis, on va la faire avec un truc qui pousse vite. Donc, on prend un petit pois. Et puis, dans les premières journées, les petits pois poussent très vite. Et en fait, ce qu'ils ont fait, ils se sont dit, voyons voir, qu'est-ce qui peut être l'équivalent de la nourriture ? L'équivalent de la nourriture, les plantes, ça mange quoi ? Ça mange de la lumière. Parce que ça prend, bien sûr, le CO2 qu'il y a dans l'air. Et puis, avec la lumière, ça va faire de la photosynthèse. Et la photosynthèse va fabriquer du carbone. Donc, la nourriture d'une plante, c'est de la lumière et du CO2. Et puis, après, ça pourrait être sensible à quoi ? Ils se sont dit, peut-être que c'est sensible au vent. Alors, ça n'a pas de neurones. C'est bizarre. Donc, on ne sait pas ce que ça va... Bref.

Alors, ce qu'ils ont fait, c'est qu'ils ont pris un tube de PVC. Ils ont mis un pot, là, avec le petit pois qui était dedans. Et ils ont fait des séances d'entraînement. Alors, à gauche et à droite, ils ont mis un ventilateur et puis une lampe à ultraviolet qui permet de faire une grosse, grosse photosynthèse, avec de la bonne nourriture pour plantes, de la lumière. Et puis, ils ont fait ça à gauche et à droite. Et donc, une session d'entraînement, c'est pendant 60 minutes, ils ont amené de l'air par un ventilateur du côté gauche. Et après 60 minutes, pendant une heure, ils ont démarré les UV. Et puis, ils ont arrêté le ventilateur 30 minutes après, etc. Donc, ça, c'était les séances d'entraînement. Ils ont fait ça à gauche. Ils ont fait ça à droite. Et qu'est-ce qui s'est passé ? Eh bien, comme on pouvait s'y attendre, quand on allume la lumière ici, le petit pois, il se tourne à gauche pour récupérer sa lumière. Et c'est normal parce que, soi-disant, ça pousse plus vite quand c'est à l'ombre. Donc, forcément, il se tourne du côté opposé où il y a la lumière. C'était la notion mécanique. Et donc, ils ont fait ça à gauche, à droite, etc. Et puis après, grosse surprise, ils ont fait le test comme Pavlov. Ils ont démarré le ventilateur à gauche. Et sans qu'il y ait de nourriture, le petit pois s'est tourné à gauche. Et si vous démarrez le ventilateur à droite, le petit pois tourne à droite. Donc, tout petit pois qu'il est, il a fait la relation entre le vent qui vient d'à gauche ou d'à droite. Et donc, il sait qu'il va y avoir de la lumière qui va à droite. Donc, il se tourne. Donc, il a appris. Il est aussi capable d'intelligence. Alors, c'est une très mauvaise nouvelle pour les... Je ne sais pas s'il y a des végétariens dans la salle. Je suis vraiment désolé. Les plantes apprennent aussi. Vous pouvez faire l'exemple. Pavlov, ça marche sur les plantes. Donc, maintenant, il faut sucer des cailloux. Je ne sais pas ce qu'on fait. Voilà. C'est beaucoup plus difficile de manger de manière éthique et sereine quand on sait que les plantes... Voilà. Bref. Donc, les plantes apprennent. Alors après, il y a tout plein d'exemples comme ça. Mais je vois que le temps passe. Ça fait déjà 43 minutes. On ne va pas rentrer là-dedans. Quel est l'animal le plus intelligent sur Terre ? Je vais vous le présenter. C'est celui-là. C'est un Caenorhabditis elegans. Alors, pourquoi est-ce que c'est le plus intelligent sur Terre ?

C'est qu'en fait, c'est une forme de télie. Les Caenorhabditis elegans ont exactement 1035 cellules. Toujours les mêmes. Mais, chose incroyable auquel on s'aperçoit quand on a disséqué ce machin-là. De ces 1035 cellules, un tiers sont des neurones. Un tiers des cellules de ce bestiaux-là sont des neurones. Qu'est-ce qu'il fout avec un tiers de ce qui le constitue comme étant des neurones ? Pourquoi est-ce qu'il a besoin d'être si intelligent que ça, ce truc-là ? Et rapporté à un humain, ça voudrait dire que notre cerveau devrait faire 15 kilos au lieu de faire 1,5 kilo. Comparé à sa masse, il a 10 fois plus de cerveau que nous, ce truc-là. C'est incroyable. C'est bien parce qu'on a fait son connectome. Comme ils sont tous absolument identiques, on a regardé tel neurone est relié à celui-là, etc. C'est quand même assez étonnant ce truc-là. Un tiers de ces cellules, c'est des neurones.

Bref. Maintenant, on arrive sur une autre notion d'intelligence qui va nous amener sur la notion d'intelligence artificielle. C'est celle de Michel Serres, qui était un philosophe qui est mort maintenant il y a trois ans. Lui, ce qu'il avait fait, c'est qu'il avait fait une proposition. C'était que la faculté de l'homme, ce qui était spécifique à l'humain, c'était d'avoir été capable d'externaliser ses fonctions corporelles. L'exemple qu'il donnait facilement, c'est que tout bêtement, si je veux boire avec ma main, je vais mettre ma main sous l'eau. Mais forcément, l'eau va tomber au milieu des trous de ma main. Autant fabriquer une main artificielle, ça s'appelle une cuillère. Une cuillère, c'est une main avec un manche. Le manche, c'est l'avant-bras. Plutôt que de faire ça avec ma main qui est percée, maintenant, je peux boire. Si j'ai un marteau, qu'est-ce que c'est qu'un marteau ? Au lieu de taper sur un clou pour me faire mal au poing, j'invente un marteau. C'est un poing en métal avec un manche en bois. C'est un avant-bras et un poing. On peut imaginer que les vêtements sont des poils amovibles. Pour lui, la capacité d'être humain, son inventivité, c'était d'être capable d'externaliser ses fonctions corporelles. Et là où c'était intéressant, c'est qu'il a fait une super vidéo que je vous conseille de regarder sur Internet.

Ça doit être la parabole de Saint-Denis. C'est le titre de la vidéo. Il raconte que quand il était lui-même étudiant en philosophie, on lui avait appris que la cognition était faite de trois facultés qui étaient dans notre tête. C'était la mémoire, l'imagination et la raison. La mémoire, ça fait un certain temps qu'elle avait déjà été externalisée. La mémoire a été externalisée quand on a fait l'écriture. Quand on veut se souvenir quelque chose, on prend des notes. Et puis après, deux ans après, on relit ces notes. Ah oui, il y avait un truc qu'on avait oublié. Maintenant, on n'est pas obligé de tout mémoriser. Donc la mémoire, on l'avait déjà externalisée.

C'est pareil avec les images. L'imagination, c'est les images que vous avez dans votre tête et les images, vous faites des peintures. Vous faites des photos, des peintures rupestres, etc. Et ça titille votre imagination. Puis après, la raison. Là, ce n'était pas facile. Mais qu'est-ce qu'on a maintenant avec les ordinateurs ? Dans les ordinateurs, on a toute la mémoire qu'on veut. Avec Internet, on a absolument tout ce qu'on veut. Après, les images, toutes vos photos de vacances, vous les avez mises dedans.

Vous avez même des films. Vous avez des choses qui vous font imaginer des choses dans des ordinateurs. Et puis, la raison, les ordinateurs sont capables de faire de la logique, de la logique inductive sans se tromper, comme certains humains. Ils sont capables de faire de l'arithmétique et tout. Finalement, c'est l'ultime stade de l'inventivité humaine. C'est qu'on a réussi à externaliser notre cerveau et la cognition.

Et maintenant, vous êtes toutes et tous, je pense ici, des humains augmentés qui n'ont pas de téléphone portable avec eux. Y a-t-il une main qui se lève ? Non. Il n'y a pas une seule main qui se lève. Donc, je vous annonce que vous êtes tous des humains qui avez externalisé votre tête.

C'est-à-dire que dans votre téléphone portable, il y a de la mémoire. Tout ce que vous avez, vos notes, vos machins, les listes de courses, des images, des photos, des films, des vidéos, etc. Grâce au GPS, ça vous fait le raisonnement pour trouver le meilleur moyen d'aller du point A au point B, etc. Vous n'avez plus besoin de le faire vous-même. Vous n'avez même plus besoin de savoir où vous habitez.

Vous pouvez vous perdre dans votre ville. Dès que vous avez ça, c'est votre cerveau qui est externalisé dans votre poche ou dans votre sacoche. Vous voyez qu'on arrive à la notion d'externalisation. Maintenant qu'on a fait toute cette présentation de la notion d'intelligence, regardons un peu la notion d'éthique. Si on peut arriver à mettre ça ensemble. Il faut comprendre que depuis l'origine de la civilisation, on va faire remonter ça à 10 000 ans environ, l'agriculture, et bien, attention, en Occident, on se rend compte qu'il y a plusieurs éthiques qui se sont succédées jusqu'au XXe siècle.

Les éthiques, ce qu'on appelle ça des méta-éthiques. Les méta-éthiques qui se sont succédées de 10 000 ans... Il faut savoir qu'elles se superposent, elles ne se remplacent pas l'une de l'autre. Elles s'ajoutent les unes aux autres. Il y avait la notion de supernaturalisme. Il faut que je fasse ça pour que ça passe à la vidéo. Le supernaturalisme, c'est-à-dire une éthique qui tient compte de Dieu, de choses qui sont au-delà du naturel, surnaturelles. Après, du XVIe siècle jusqu'à maintenant, c'est ce qu'on appelle le relativisme culturel et avec ce qu'on appelle l'éthique républicaine. On va regarder un peu plus rapidement, un peu plus en détail ce que c'est. Maintenant, on a une éthique basée sur l'individu et une éthique basée sur les personnes, basée sur les gens. La question qu'on va se poser maintenant, c'est est-ce qu'on a des nouvelles méta-éthiques qui sont apparues au XXIe siècle, qui est le siècle dans lequel nous vivons.

Regardons un peu la notion de méta-éthique super naturelle. C'est ce qu'on appelle une éthique aristocratique en Grèce. Elle est fondée sur trois choses. Les lois sont des lois hétéronormées. Ce sont les lois qui proviennent des dieux, les lois de Moïse, etc. qui nous sont données par les dieux. On a vu la stèle avec le dieu qui donnait la liste de lois à Hammourabi. C'est très important de comprendre qu'à l'origine, dans le cosmos grec, le cosmos est parfait parce qu'il a été créé par les dieux. Comme le cosmos est parfait, il faut que les humains essayent de refaire ce qu'il y avait à l'origine parce qu'à l'origine, c'était parfait.

C'est ça l'origine de la tradition. Pourquoi il faut refaire ce qui a été fait précédemment ? Parce qu'à l'origine, c'était nickel. C'était parfait, c'était fait par les dieux. Donc, si mon papa est bouché, il faut que moi-même, je sois bouché pour remplacer mon papa et je ne suis pas censé faire autre chose. Sinon, c'est ce qu'on appelle l'éducation et c'est l'étymologie ex ducere. Je vous laisse regarder ça, de quoi il s'agit. C'est très subversif, l'éducation.

L'éthique est ici. En fait, elle est hiérarchique. Les fermiers ne peuvent pas devenir des seigneurs. Le fils du seigneur sera forcément le seigneur parce qu'on refait ce qui s'est passé précédemment. De manière intéressante, lorsqu'il y a des pièces du puzzle du cosmos parfaitement ajustées qui sortent de l'ajustement, quand on a un humain qui vole, qui tue, etc., des animaux qui volent, ils sortent de l'ajustement.

Où est-ce qu'on les amène ? On les amène devant la justice. L'objet de la justice, c'est de réajuster les gens au cosmos. C'est ça l'étymologie. Il y a une pièce du puzzle qui est partie, on la ramène. La justice, on vous réajuste. Ça fonctionne aussi avec des animaux. Il y a eu des célèbres procès d'animaux dans le passé. Ça, c'était la première éthique. Une nouvelle éthique s'est rajoutée à partir du moment où on a développé un peu la science. La science s'est développée notamment avec Newton.

Newton a fait un truc super bizarre, c'est qu'il a créé une loi. Normalement, c'est les dieux qui créent les lois. Mais les lois des dieux, on se rend compte qu'elles sont spécifiques à un groupe d'humains. C'est-à-dire que l'éthique en France va être différente de l'éthique en Angleterre, qui va être différente de l'éthique en Afrique, l'éthique en Chine, etc. Les lois qui vont nous permettre d'interagir de manière sans conflit, ça ne va pas être les mêmes suivant l'endroit où on se trouve. Donc c'est des éthiques locales, localisées. Mais quand c'est la science, Newton, ça fonctionne partout. Si c'est un Africain qui vous jette un caillou, la trajectoire va être parabolique.

Si c'est un Chinois, si c'est un chimpanzé qui vous jette un caillou, le caillou va avoir la même trajectoire. Donc là, ce sont des lois qui sont maintenant universelles. C'est ça qui va définir la science. C'est que les lois scientifiques fonctionnent partout, ne sont pas spécifiques à un groupe d'humains, ne sont pas spécifiques à une localisation.

Donc ils se sont dit, c'est bizarre, les lois faites par les humains, déjà on est capable d'en faire, et ensuite elles sont meilleures que les lois traditionnelles, que les lois des dieux. En fait, ce qui s'est passé, c'est que ce truc-là a cassé la notion de loi divine qui était forcément au-dessus de tout, puisque nous on est capable d'en faire, qu'elle soit meilleure. Et deuxièmement, ça a cassé aussi la tradition, pour une autre raison, qui est liée au christianisme, et qui est liée à la parabole des talents.

Mais je vois le temps qui passe, et on n'aura pas le temps d'en parler ici. Donc en fait, ce qui s'est passé, c'est que la deuxième éthique, qui est l'éthique républicaine, elle a supprimé la notion de Dieu, qui n'était plus là pour fabriquer les lois, donc on n'est plus hétéronome, on devient autonome, la notion de tradition, via l'éducation, parce qu'en fait, via l'éducation, je vais en parler en deux mots, ex ducere, c'est en dehors d'eux, épiler c'est sortir les poils, effeuiller c'est enlever les feuilles, donc c'est en dehors d'eux. Et ducere, le duc, la conduite, c'est la direction. Et le duc, il est censé vous dire où vous devez aller, ce que vous devez faire. Et éduquer, c'est ex ducere, c'est sortir une personne de la voie qui était la sienne. Je suis ingénieur, tu seras ingénieur mon fils, je suis docteur, tu seras docteur mon fils, et si le fils n'est pas bon en maths, il va aller à l'école, et puis à l'école, il aura l'opportunité d'être éduqué, c'est-à-dire que finalement, peut-être qu'il va faire de la philo, peut-être qu'il va faire de la musique, ou il va faire autre chose, et voilà, il est sorti de sa voie.

Donc c'est ça l'éducation. Mais en fait, il est resté la notion d'hiérarchie. Alors la notion d'hiérarchie, ça c'est le fait que, dans toutes ces éthiques-là, les premières et les deuxièmes éthiques, la hiérarchie c'était d'abord les inanimés, après il y a les animaux, non-humains, les handicapés c'est à peu près au même niveau, on ne sait pas trop quoi en faire,

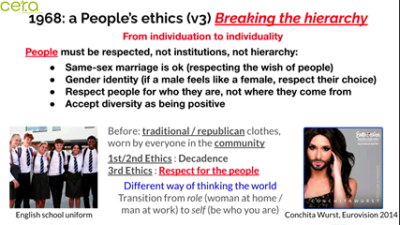

Hitler il est passé au four, et puis après il y a les enfants, les femmes, les hommes, et Dieu. Donc c'est ça la grande hiérarchie de la première éthique. La deuxième éthique, on supprime Dieu, mais il y a encore toute la hiérarchie. Et ça, la troisième qui est arrivée par la suite, et bien en fait c'est le respect de l'individu et le respect de la personne. Alors le respect de la personne, c'est arrivé justement en France, comme très souvent, les révolutions. Donc 68, révolution étudiante contre la hiérarchie totale des professeurs, des mandarins de l'université, et ça a une résonance avec les Etats-Unis, parce que les Etats-Unis ça a été avec la guerre du Vietnam.

La guerre du Vietnam, 70, les Américains ont dit, mais pourquoi est-ce que moi je devrais aller donner ma vie au Vietnam, les gens je ne les connais pas là-bas, je n’ai rien à y faire là-bas, en fait c'est l'Etat, la hiérarchie qui me dit vous allez au Vietnam et vous allez mourir au Vietnam parce que je vous demande d'y aller. Les Américains, les gens ils ont dit, mais pourquoi est-ce que j'irais mourir là-bas ? Il n'y a aucune raison. Donc en fait, la seule raison d'aller mourir au Vietnam, c'était la hiérarchie. Donc c'est ça qui a fait cette révolution qu'il y a eu en même temps en France et aux Etats-Unis, et donc ça s'est vu avec, bien sûr, toutes les choses, et on se rend compte que tout date des années 68, des années 70, etc. Donc voilà, aux Etats-Unis, mon fils a été tué au Vietnam, pourquoi ?

En bas, à Balergy-Mgolis, le peuple veut le pouvoir, donc arrêt de la hiérarchie. Et puis, voilà, la série Le prisonnier, 1967, je ne suis pas un numéro, je suis un homme libre. Donc cette revendication de la liberté et la revendication d'exister en tant que personne indépendante et indépendamment de la hiérarchie. Alors ce qu'il y a, cette troisième éthique, en fait avant la personne devait le respect et donner sa vie à la hiérarchie et donc aux institutions et ce qui est découlé de ça, ça a été une inversion du truc où maintenant, ce sont les institutions qui sont à notre service. Là, récemment, aux Etats-Unis, il y avait une personne qui était en train de se faire arrêter par la police, mais injustement, qui dit aux policiers, ben non, écoutez, c'est vous qui travaillez pour moi, c'est moi qui vous paye, c'est moi qui paye la police, vous êtes à mon service, d'accord ?

Ce n’est pas moi qui dois respecter ce que vous demandez, c'est le contraire. Vous voyez, c'est vraiment une inversion de la notion de hiérarchie et maintenant, ce sont les humains, c'est la hiérarchie, c'est les institutions qui sont là pour servir les humains qui composent la société.

Donc, alors, il y avait tout plein de choses à l'époque, avec, bien sûr, la cage aux folles, village people, etc. Avec des paroles, alors de manière intéressante, I am what I am, il y a eu deux versions. La première version, village people 78, les gens ont le droit d'être juste qui ils sont, les gens ont le droit de partager tout leur amour, les gens ont le droit de partager juste ce qu'ils peuvent donner, le droit à leur volonté libre. Ils ont le droit de vivre avec qui ils veulent, 78. Ils ont le droit de vivre là où ils veulent de manière heureuse et personne n'a le droit de choisir mon amour pour moi, je suis né libre. Ça dit tout. Et puis après, version Gloria Gaynor, voilà, il faut une vie complète pour être la meilleure personne qu'on peut être. Nous n'avons pas le temps ou le droit de juger, de nous juger les uns les autres. Je suis qui je suis ou je suis ce que je suis.

Je ne veux pas qu'on me félicite et je ne veux pas de pitié. Je fais ma propre musique. Pour certains, c'est du bruit, mais moi, je trouve que ma musique, elle me plaît bien, elle est belle. Je suis qui je suis et je n'ai pas besoin d'excuses, c'est moi qui joue mon propre jeu, mon propre jeu de cartes, c'est moi qui dis ce que j'en fais, c'est ma vie. Vous voyez que c'est vraiment fondamental de cette troisième éthique.

Alors cette troisième éthique, eh bien en fait, on se rend compte que l'objet de cette troisième éthique c'est de casser la hiérarchie. Donc casser la hiérarchie, maintenant, eh bien, il faut respecter les gens et typiquement, ça passe par le mariage gay, le mariage homosexuel, les endroits où s’est accepté, ça veut dire que, alors dans les endroits hiérarchiques, on dit, ben non, la loi c'est un homme marié avec une femme, mais si les institutions doivent respecter les gens, ben un homme veut épouser un autre homme, pourquoi pas, respectons leur choix. Alors, ce qui est vu comme étant la décadence dans les premières et deuxièmes éthiques, Et bien en fait, dans la troisième éthique, c'est vu comme étant le respect des genres. Donc dans les premières, deuxièmes éthiques hiérarchiques, on a la notion d'uniforme qu'on voit ici en Angleterre. Et puis là, en 2014, l'Europe a élu Conchita Wurst comme étant meilleure chanteuse de l'Eurovision.

Donc voilà, vous voyez complètement l'évolution des mœurs. Cette personne-là n'est plus jugée sur son apparence, sur qui elle veut être, mais sur ce qu'elle fait, sur sa chanson, etc. Et c'est comme ça qu'elle a été élue. Donc maintenant, regardons ces notions de méta-éthique. Et en fait, il y a un moyen intéressant de la regarder, c'est via le prisme du ce qu'on appelle le sacrifice. Le sacrifice, c'est ce pour quoi vous êtes prêt à donner votre vie. Et alors, si on regarde l'éthique numéro un, pour qui est-ce que vous êtes prêt à donner votre vie ? Typiquement, c'est pour la religion, parce que c'est l'éthique de Dieu. Donc, la dévotion, mais aussi donner sa vie. Alors là, il y avait un événement qui était en 1963, qui a choqué toute l'Amérique. C'était un bouddhiste qui s'est immolé par le feu contre les catholiques romains. Et ce qui était très intéressant, c'est le commentaire qui a été fait par les bouddhistes de ce truc-là. Ce n'était pas un suicide, c'était un acte dévotionnel de pratique incarnée. C'était le mot qui a été utilisé, un acte dévotionnel de pratique incarnée. Ce n'est pas un suicide. Il a donné sa vie pour son groupe, pour son dieu, pour...

Alors, il n'y a pas de dieu en plus. Un bouddhiste, il n'y a pas de dieu. Donc, vous voyez bien que c'est vraiment une notion de religion sans dieu. Donc, c'est très intéressant de voir ce qui était là. Et là, on est complètement dans la première éthique. Alors, la deuxième éthique, c'est quoi ? Eh bien, c'est le respect de la hiérarchie. Vous êtes capables de donner votre vie pour le Vietnam, pour... Pour vous dire à quel point ça a évolué, je pense que... Attention, il va y avoir un grand éclat de rire dans la salle. Dans la salle, combien de personnes sont prêtes à donner leur vie pour Emmanuel Macron ? Peu. Peu de personnes sont prêtes à donner leur vie pour Emmanuel Macron. Eh bien, de manière très intéressante, ça, c'est ce qu'on appelle l'éthique républicaine.

La république, res publica, la chose publique, qui doit être au-dessus des personnes. Eh bien, quand la chose publique doit être au-dessus des personnes, ça nous a donné, il y a deux semaines, un... Donald Trump, qui, lors des élections, je crois que c'était en Iowa, où il a fait un temps absolument épouvantable, avec moins 30, moins 40 degrés. Eh bien, qu'est-ce qu'il a dit ? Il a dit à ses supporters que ça vaut le coup d'aller voter pour lui dans le froid, même s'ils sont malades comme des chiens et même s'ils meurent après avoir mis leur bulletin de volte. C'est la définition mourir pour son chef. C'est la définition de l'éthique numéro 2 républicaine. C'est ça, la république. Res publica, c'est plus important. Votre vie est au service de votre institution. Votre vie est au service du groupe. Même si vous mourez après, c'est important de voter pour moi, qui suis bien sûr votre chef. C'est la république, exactement ça. Alors, du coup, la troisième éthique, pour qui est-ce que vous êtes capable de donner votre vie ? Est-ce que les humains en France sont capables de donner leur vie pour quelque chose, pour quoi, etc. ? Est-ce qu'on fait un sondage que quelqu'un est capable de donner sa vie pour quoi ? Pour une personne, pour l'autre, pour ses enfants, pour sa famille, etc. ? Donc, vous voyez qu'on n'est plus prêt. Maintenant, on ne va plus donner notre vie en France pour Dieu. On ne va plus donner notre vie pour Macron ou pour les institutions parce que votre chef a dit va mourir là-bas. On n'y va pas. Non, c'est fini, ça. Mais par contre, ben voilà. Alors du coup, j'ai ça. C'était un papier Zerugo magazine, etc. Mother's love and sacrifice for her child is supreme. L'amour de la mère et son sacrifice pour son enfant est suprême. Et ça, c'était là c'était la photo qui allait avec. Donc là, on est complètement dans la troisième éthique. On respecte les individus et on respecte plus du tout l'institution. Enfin, c'est l'inverse. L'institution, maintenant, est au service des individus. Bon, est-ce qu'il y a quelque chose de nouveau dans le 21e siècle ?

Parce que là, pour l'instant, c'est les trois éthiques. Alors attention, elles existent toujours. Il y a toujours des gens qui croient en Dieu actuellement en France. Il y a toujours des gens qui croient dans une institution et dans un chef suprême et que c'est important. Et puis, il y a des gens qui croient. Les trois éthiques cohabitent. Ce sont des éthiques qui s'ajoutent les unes les autres. Alors, maintenant, je vous ferai remarquer qu'il y a des ordinateurs qui sont partout, qui sont interconnectés. Il y a des informations numériques qui sont associées à pratiquement tout le monde. Il y a des réseaux sociaux qui sont présents partout. Alors maintenant, l'éthique que je vais proposer, donc là, maintenant, on va arriver dans mon travail de recherche, c'est est-ce qu'on a une nouvelle éthique qui serait l'éthique de la délocalisation ? Alors, c'est très intéressant la notion d'adresse. C'est la suivante. C'est que maintenant, vous êtes d'accord qu'on est tous. On a tous un smartphone attaché à nous. Donc, nous sommes augmentés de cette manière-là. Les satellites, les constellations satellites font que partout où on est dans le monde, on est localisé. On a accès à Internet. On a accès. Voilà, quand il y a un trou, on n'est vraiment pas content.

Quand on prend le train et qu'on arrive à choler des fois des endroits qui ne sont pas bien, qui ne sont pas bien pavés d'un point de vue Internet. On est là à pester. Voilà, tous les objets sont communicants, interagissent. Les données sont toutes collectées par les sociétés. C'est ce qu'on appelle Internet of Things, l'Internet des choses. Et donc, en fait, la notion de nouvelle éthique, pour moi, elle est délocalisée, délocalisée dans le sens où les trois premières éthiques, donc l'éthique des dieux aristocratiques, l'éthique républicaine et l'éthique démocratique, en fait, elles sont localisées dans le sens où les lois en France ne sont pas les mêmes que les lois en Angleterre, que ne sont pas les mêmes que les lois en Allemagne.

Les lois en France ne sont pas les mêmes que les lois en Alsace. Je vis en Alsace. Enfin, je vivais jusqu'à la semaine prochaine. Et en Alsace, il n'y a pas de loi 1905 parce que la loi en Alsace, en 1905, l'Alsace était allemande. Donc, ce n'est pas passé. Donc, en Alsace, il y a une loi d'association qui est une loi 1906. Les associations ont le droit de faire des bénéfices. Je ne sais pas à qui ça peut intéresser les gens, mais vous aurez le droit de faire des bénéfices si vous fondez une association en Alsace, mais pas en France. Les lois ne sont pas les mêmes. Mais les lois sont donc attachées à un endroit. Eh bien, en fait, cette notion, c'est la notion d'adresse qui comporte trois choses. C'est ad directus. Alors premièrement, quand je vous dis j'habite à Strasbourg, vous savez où je suis, grosso modo dans l'est de la France, au nord d'ici. Vous êtes capable de me localiser. C'est la localisation géographique. Après, dans directus, il y a la notion de rectus et le droit. Vous savez à quel droit je vais répondre si vous faites affaire avec moi. Attention, il est alsacien et donc ce n'est pas les mêmes lois en Alsace qu'en France. Donc, quand je vais faire des affaires, il faut savoir à qui on a affaire parce que moi, je ne peux pas sortir de mon droit alsacien. Alors bon, il y a le concordat. Il y a des trucs comme ça. Ce n'est pas la même chose. Donc, quand on fait des affaires entre eux, il faut connaître la loi de l'autre. Et la dernière chose que porte une adresse, eh bien, c'est rectus. Directus vient de rectus, qui est la loi. Le roi, ça donne votre environnement politique. Est-ce que vous êtes dans un royaume ? Est-ce que vous êtes dans une démocratie ? Dans une dictature ? Dans une autocratie ? Dans une... etc. Tout ce que vous voulez. Donc, ça dit quel est votre environnement politique. Ça, c'est les trois choses qui sont liées à une adresse.

Maintenant, mon adresse à moi, c'est [email protected]. Bon, pierrecollet at gmail.com. J'habite où ? C'est quoi les lois que je dois suivre ? Et c'est quoi mon régime politique ? Est-ce qu'il y a une démocratie ? Monarchie ? Monarchie constitutionnelle ? Enfin, tout ce que je veux. Je ne sais plus rien de ça. Maintenant, on arrive dans une nouvelle ère où, quand il n'y a plus d'adresse, on se retrouve à l'époque du Moyen-Âge. Et à l'époque du Moyen-Âge, il y avait des villes. Je reprends ça de Michel Sark qui avait tout compris. Dans les villes, c'était le pouce du seigneur de la ville. Le pied, c'était le pied du seigneur de la ville. Quand vous changez de ville, les marchands s'adaptaient aux nouvelles longueurs, aux nouvelles dimensions. Donc, il y avait la loi du seigneur local de la ville. Enfin, tout était géré par le seigneur local. Et entre deux villes, que faisaient les bourgeois ? Ils couraient très vite parce qu'ils étaient dans la forêt. Et dans la forêt, c'est la loi de qui ? Il n'y a pas de loi.

Mais en fait, ce n'est pas vrai parce que des zones de non-loi et de non-droit émergent de nouvelles lois. Et donc, il y avait dans la forêt en Angleterre, dans la forêt de Sherwood, un mec qui s'appelait Robin Hood, Robin des Bois. Et qui c'est Robin des Bois ? C'est bizarre parce qu'à cette époque-là, qui sont les humains et les hommes qui portent des robes ? Normalement, les robes, c'est les femmes. Mais en fait, Robin avait une robe. Les gens qui ont des robes, c'est des magistrats, c'est des juges, etc. Donc, ça veut dire que quand vous êtes dans ma forêt à Sherwood, vous suivez ma loi de Robin. C'est moi qui ai la robe et c'est moi qui dis que c'est les riches qui donnent aux pauvres. Et donc, il a défini ses propres lois. C'était marrant parce que l'usurpateur, c'était Jean Santerre. Donc, c'est Jean Santerre qui n'avait pas de terre. En anglais, c'est intéressant parce qu'il s'appelle Robin Hood. Et le Hood, c'est quoi ? C'est la capuche. En France, on a un ordre, c'est l'ordre des capucins. C'est quoi les capucins ? Le capuce, etc.

C'est ce qu'il y a au-dessus de la tête. Et qui c'est qui ont une capuche ? C'est des religieux. Et les religieux, c'est eux qui disent l'éthique. C'est eux qui disent comment on doit se comporter les uns avec les autres. Et donc, Robin Hood, ça veut dire que quand on est dans la forêt de Sherwood, on doit suivre les lois de Robin et puis on doit se comporter de manière religieuse à la manière dont Robin dit qu'on doit se comporter. C'est l'éthique de Robin qui fonctionne. On se rend compte que des entités, des nouvelles lois, etc. émergent des zones de non-droit, émergent de la forêt. Et bien, qu'est-ce qu'il y a qui émerge de la forêt en ce moment ? Actuellement, on a des entités qui sont non localisées, qui s'appellent Google, Amazon, Uber, Airbnb, Instagram, Meta, etc. Et qu'est-ce qui émerge ? La première chose qui doit émerger quand on a des nouvelles entités qui doivent interagir, échanger, etc. Ah bah tiens, c'est des nouvelles valeurs. Les nouvelles valeurs, ça s'appelle les blockchains. Et les blockchains, ça permet de faire quoi ? Tiens, ça permet de faire de l'argent. Bitcoin, quel est l'état ? Bitcoin dépend de quel état ? Est-ce que Bitcoin, c'est américain ? Est-ce que c'est africain ? Est-ce que c'est chinois ? Est-ce que c'est japonais ? Non, Bitcoin est hors-sol. Ça n'existe de nulle part. Mais c'est une monnaie d'échange. Mieux que ça, il y a le Dogecoin, etc. Donc on voit qu'il y a des monnaies qui émergent. De l'art non-fongible, le Nyan cat qui est ici, les pixels qui sont là, cette superbe création, cette œuvre d'art a été vendue. 580 000 dollars à quelqu'un qui a acheté ça. 580 000 dollars, c'est un NFT, un des premiers. Et donc on se rend compte que finalement, on arrive dans une méta-éthique qui est l'éthique de la globalisation, moi j'appelle ça de la dislocation.

Parce qu'il n'y a plus de localisation, on n'est plus attaché à un endroit. Alors c'est là où il se passe, il y a des notaires dans la salle. Les notaires sont super importants parce que les notaires sont ceux qui sont capables de prendre ces entités, de les enraciner à l'endroit où l'étude de notaire se trouve. A faire que l'entreprise qui est ralliée va s'enraciner à un endroit où il y a des règles qui existent. Mais sans ça, l'entité est hors sol et ne répond absolument à aucune loi. Alors la preuve, c'est que le 22 janvier 2024, c'est pour ça que je mets à jour mes transparents, le 22 janvier c'était il y a peu de temps, le gouvernement de la Flandre essaye de forcer TikTok et Youtube à partager leurs revenus.

Pourquoi est-ce que TikTok paierait des impôts en France ? Bah non, TikTok, nous on est désolé, on n'est pas français. On n'est pas belge, on n'est pas machin, il n'y a pas de raison qu'on paye des impôts chez vous.

Et puis c'est pareil pour Uber, c'est pareil pour tous ces trucs-là, ils ne sont pas localisés. En n'ayant pas localisé, ils ne suivent pas. Quelle loi vous suivez ? Bah pas les lois françaises. De toute façon, vous n'avez pas de raison, je ne suis pas français. Vous payez des impôts à qui ? Bah pas en France non plus. Donc vous voyez que c'est vraiment une notion de nouvelles entités qui vont interagir sans localisation. Donc ça pour moi, c'est un nouveau truc qui n'existait pas avant.

Et à tel point que, alors ça c'est un petit peu plus vieux, donc 4 février 2022, Carrefour a acheté 36 hectares de je ne sais pas quoi, dans Sanbao. Sanbao, c'est un espace virtuel, et ils ont payé les 36 hectares 300 000 euros. Et ensuite, ils s'en sont servis, en mai 2022, ils ont fait leur première session de recrutement dans le Métavers. Donc c'était ici. Il y a des gens qui ont fait des entrevues, etc. dans le Méta, chacun était chez soi, devant son ordi, voire avec un casque virtuel. Il y avait des interviewers qui étaient avec un casque virtuel chez Carrefour, ou peut-être pas. Peut-être qu'ils étaient en Inde, ou peut-être qu'ils étaient ailleurs, parce que ça coûte moins cher. Et donc, il y a eu des recrutements qui se sont faits, de manière complètement virtuelle, dans un espace virtuel. Mais par contre, ils ont quand même payé 300 000 balles pour avoir 36 hectares, dans ce monde complètement virtuel.

En 2022, il y a le premier Métavers, le collège Métavers en France. Donc c'est un master. Il y a des licences et 3 masters. Il y a un master en finance, blockchain et méta-État. Le deuxième master, c'est en art non-fongible, conception d'art digital. Et le troisième, c'est en développement de données, conception de monde virtuel, gestion de ces trucs-là. Donc vous voyez que ça commence à devenir sacrément de plus en plus réel, des choses qui sont complètement virtuelles. Et donc, je vous présente un humain augmenté, ça c'est les lunettes d'Apple qui sont sorties il y a 3 jours, quelque chose comme ça, qui vous permettent d'être de vive dans votre monde virtuel. Avec des problèmes, il y a des gens qui conduisent des Tesla, et pendant que les gens sont dans la Tesla qui conduit toute seule, ils ont leur casque de réalité virtuelle, ils ont leur casque de méta. Si vous regardez sur les infos, c'est hier, c'est absolument en ce moment,

Les États se demandent, est-ce qu'on peut conduire des Tesla en ayant ce masque sur la figure ? C'est ça la question qui est posée, et qui est une vraie question. Donc, pour moi c'est une nouvelle éthique, c'est une nouvelle manière, c'est la dislocation, on vit pour quoi ? On vit pour une deuxième vie virtuelle, en espérant qu'elle sera meilleure que la première, est-ce que c'est l'égocratie, pas d'intérêt contre d'autres humains ? C'est des vraies questions pour moi.

Alors maintenant, on a parlé de l'IA, est-ce que l'IA modifie l'interaction entre les êtres humains ? Est-ce que l'IA pourrait amener à une éthique version 5 ? Que j'ai appelée ASICS, en anglais ça passe bien, ce n’est pas SX, c'est ASICS. Alors, jusqu'à l'IA, en fait, l'éthique c'était la manière dont les humains interagissaient entre un humain et un autre humain, et bien l'ASICS ça serait comment deux humains interagissent par l'intermédiaire d'une IA. Est-ce que ça existe déjà ça ?

Écoutez, si vous allez faire un prêt à votre banque, c'est pas, en fait, je vais vous donner un secret, c'est pas votre banquier qui va vous accorder le prêt ou pas, c'est qu'en fait, le banquier vous dit, ah oui, monsieur Collé, c'est un très bon client, etc., on vous accorde le prêt, mais en fait c'est l'ordinateur qui a dit avant, et bien oui, il a toujours payé ses factures, il a une grosse voiture parce qu'à chaque fois qu'il va prendre de l'essence, votre banquier sait qu'à chaque fois que vous allez chez Carrefour pour les factures d'essence, il regarde le prix que vous mettez.

Et donc si vous mettez de l'essence 20 euros par 20 euros, ça c'est un mec qui est bizarre, il n'a pas beaucoup de fric, il met de l'essence quand il peut, et tout ça, ça rajoute des indicateurs qui sont dans l'IA qui disent, ça c'est un mec bizarre, il met de l'essence 20 euros par 20 euros, 10 euros par 10 euros, ce n’est pas normal. Donc en fait il y a plein d'indicateurs comme ça dans la science des données qui servent à savoir si vous êtes bankable ou pas, mais c'est pareil dans les assurances. Les assurances, est-ce qu'on va vous assurer ou pas ?

Ah oui, mais vous avez eu le cancer ? Oui, mais il est fini mon cancer. Ah d'accord, mais vous avez quand même eu le cancer. Et puis bien entendu, ça vous le savez. Et ça maintenant, ce sont toutes des IA, mais ça, ça fait 20 ans que ça existe, ça fait 20 ans que c'est l'IA qui décide pour vous de ce que vous allez pouvoir faire ou de ce que vous n'allez pas pouvoir faire. Donc là on est vraiment dans la notion que si oui ou non, vous pouvez avoir votre prêt ou vous pouvez avoir votre assurance, mais en fait, entre deux, c'est l'IA qui décide. Bon, avec des excès pour nous qui sont en Chine avec des pénalités suivantes. Et maintenant, est-ce que du coup nous devons changer notre comportement en tant qu'être humain en sachant qu'on va se faire évaluer par une IA ? Donc actuellement, on vient de sortir le 19 décembre 2023, une information.

Maintenant, quand vous verrez une voiture, alors je crois qu'il y avait déjà le truc pour une Renault qui avait des feux bleus pour montrer qu'elle était électrique, là maintenant ça va être différent. Maintenant, quand une voiture a un feu bleu qui est allumé, ça veut dire qu'elle est conduite de manière autonome.